在当今这个信息爆炸的时代,我们每天都需要面对海量的数据和复杂的问题。如何在这些信息中找到我们真正需要的、有价值的内容,成为了我们共同的挑战。Deepseek,作为一款集智能搜索与深度思考于一体的创新工具,正以其独特的功能和多样的使用方式,为我们提供了一个全新的解决方案。

Deepseek不仅支持在手机端APP的便捷安装与使用,让我们能够随时随地获取所需信息,还提供了电脑PC端的网页登录和平台软件安装选项,满足了我们在不同场景下的需求。无论是通过手机应用市场的快速安装,还是电脑网页的直接访问,Deepseek都以其简洁明了的操作界面和强大的功能,赢得了用户的广泛好评。

更令人兴奋的是,Deepseek还支持通过API远程调用云端算力模型,以及本地部署大模型的高级功能。这意味着,对于有一定技术基础的用户来说,他们可以更加灵活地运用Deepseek,将其集成到自己的系统中,实现更加定制化和智能化的应用。无论是硅基流动、cherry studio等平台的无缝对接,还是Ollama等基础环境的搭建,Deepseek都为我们提供了详尽的指导和支持,让我们能够轻松上手,享受科技带来的便利。

在接下来的内容中,我们将详细介绍Deepseek的各种使用方式,从手机端APP的安装与使用技巧,到电脑PC端的网页登录、平台软件安装,再到通过API远程调用和本地部署的高级功能,全方位展示Deepseek的多样性和实用性。让我们一起踏上这段探索Deepseek的旅程,共同开启智能搜索与深度思考的新篇章吧!

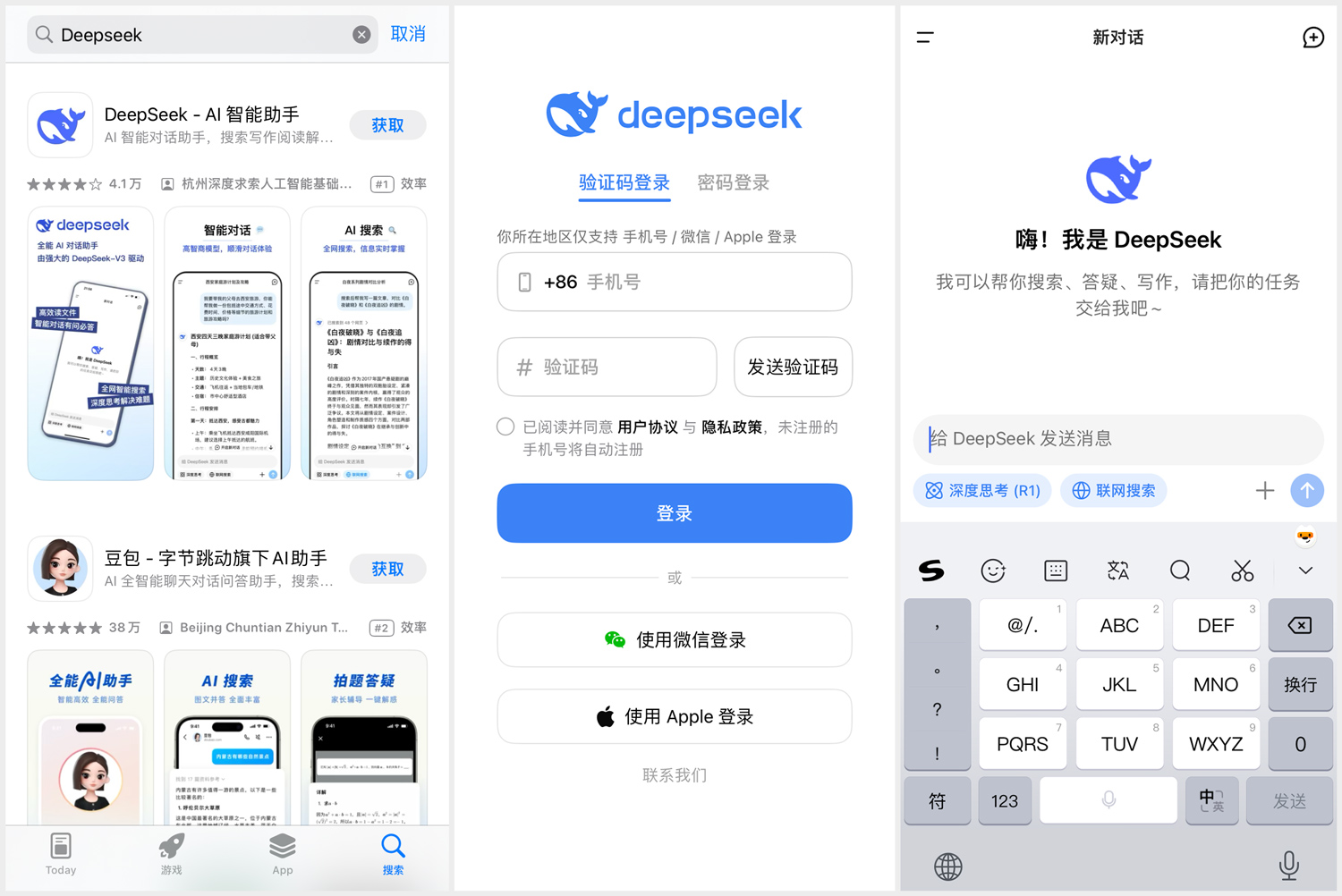

一、手机端APP安装

1.打开手机的应用市场(打开应用市场 → 输入“DeepSeek”并搜索 → 点击安装DeepSeek → 支持手机号/微信/Apple ID 三种注册方式→ 开始使用。

2.使用小技巧:手机APP端左下角有一个“深度思考(R1)”和“联网搜索”,如果你不点这两个,DeepSeek能够很快的回答你的各种问题,但是都比较基础,如果你同时点上“深度思考(R1)”和“联网搜索”它则会通过底层核心的逻辑推理和思考,并且从网上搜索相关资料,以非常专业的方式来回答你的各种问题,但是相对的,出结果的速度会比较缓慢。

二、电脑PC端网页登录

1.打开电脑网页→输入“www.deepseek.com”→点击“开始对话”即可开始使用。

2.同样,在网页端也有一个“深度思考(R1)”和“联网搜索”。

三、电脑PC端安装平台软件通过API远程调用云端算力模型

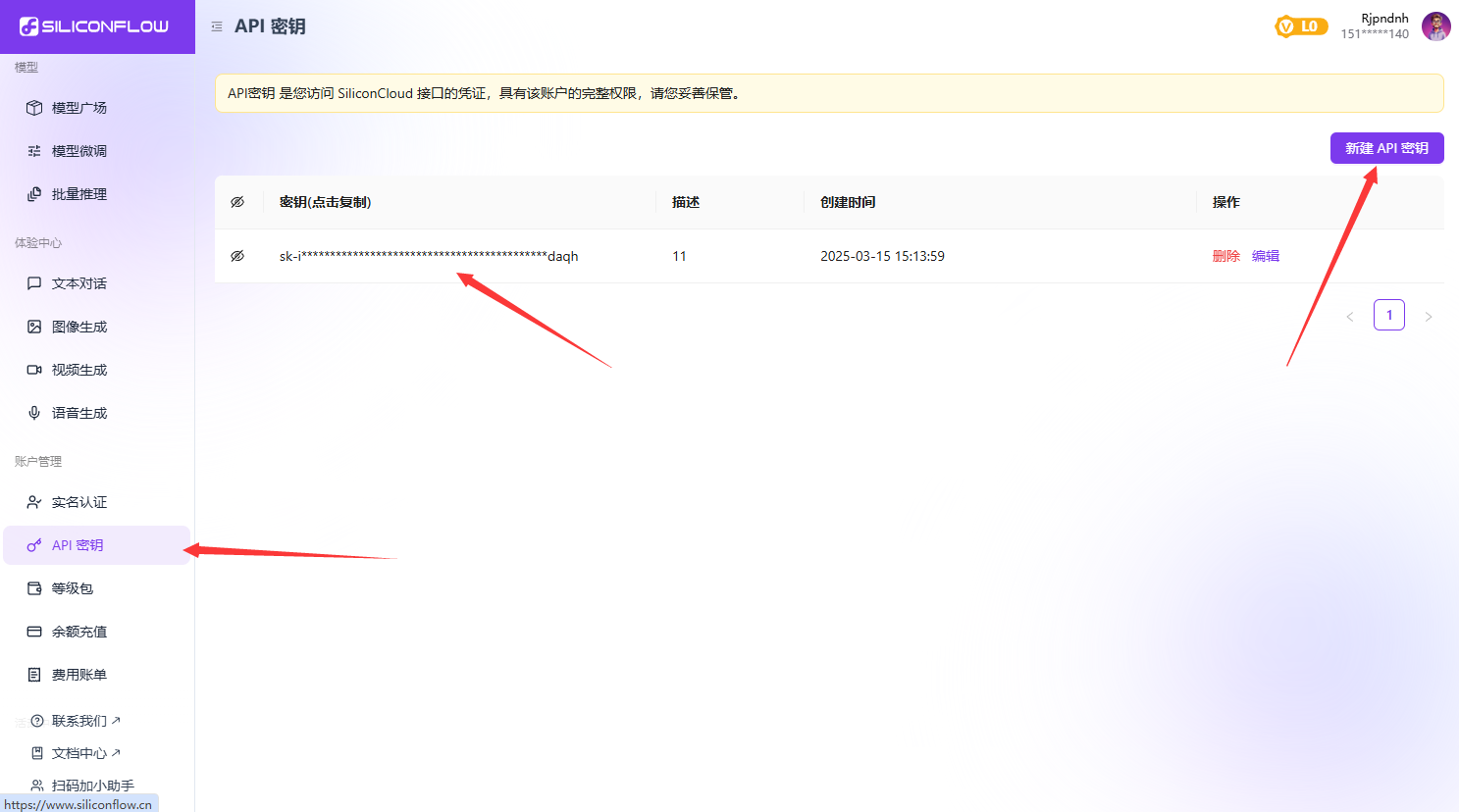

以硅基流动和cherry studio为例:

1.打开电脑浏览器,输入https://cloud.siliconflow.cn/ 使用你的手机号码来进行注册

2.点击左侧边栏的API密钥 → 点击右边的新建API密钥

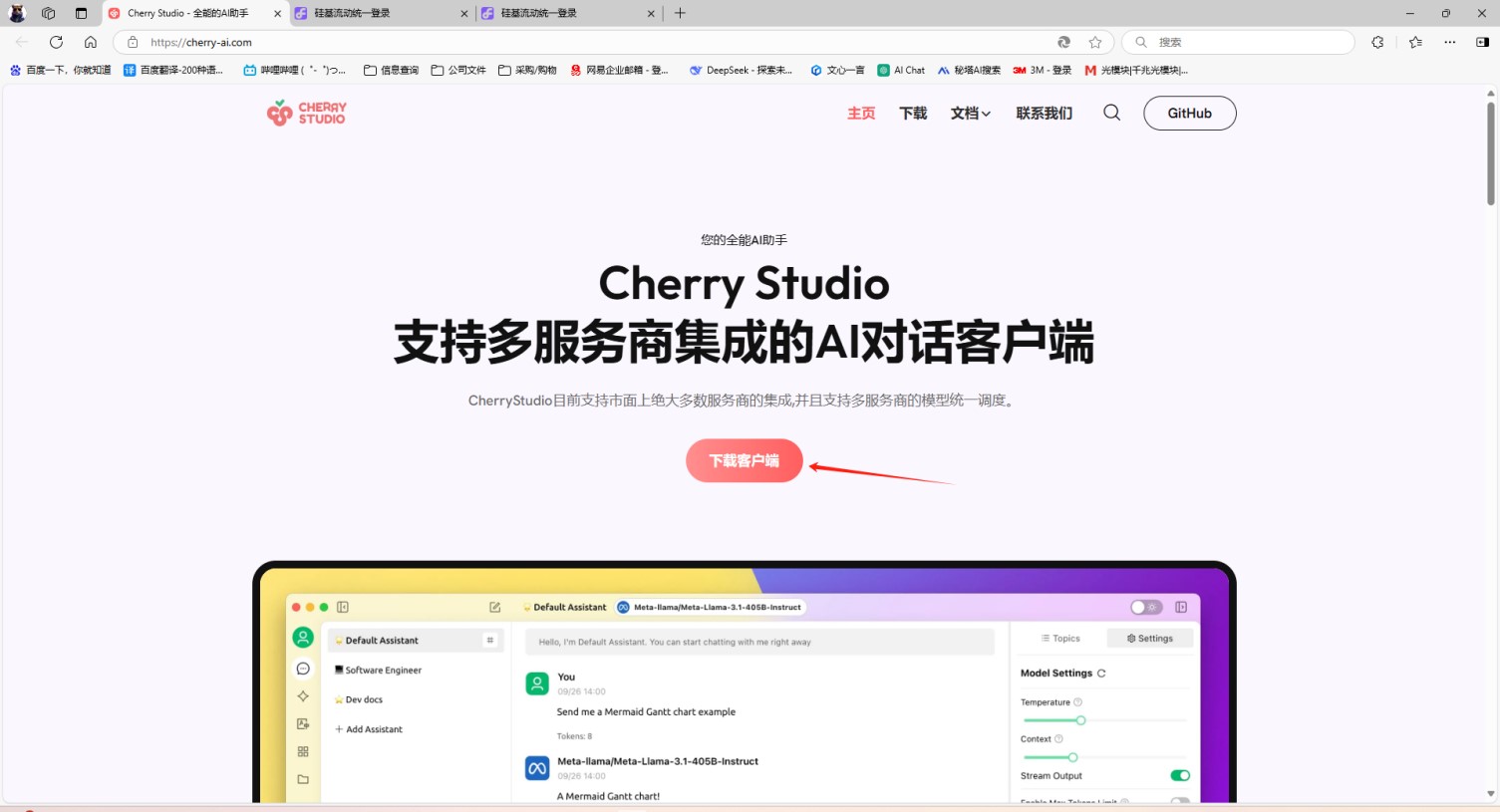

3.另启一个网页,输入https://cherry-ai.com/ 安装CherryStudio电脑客户端

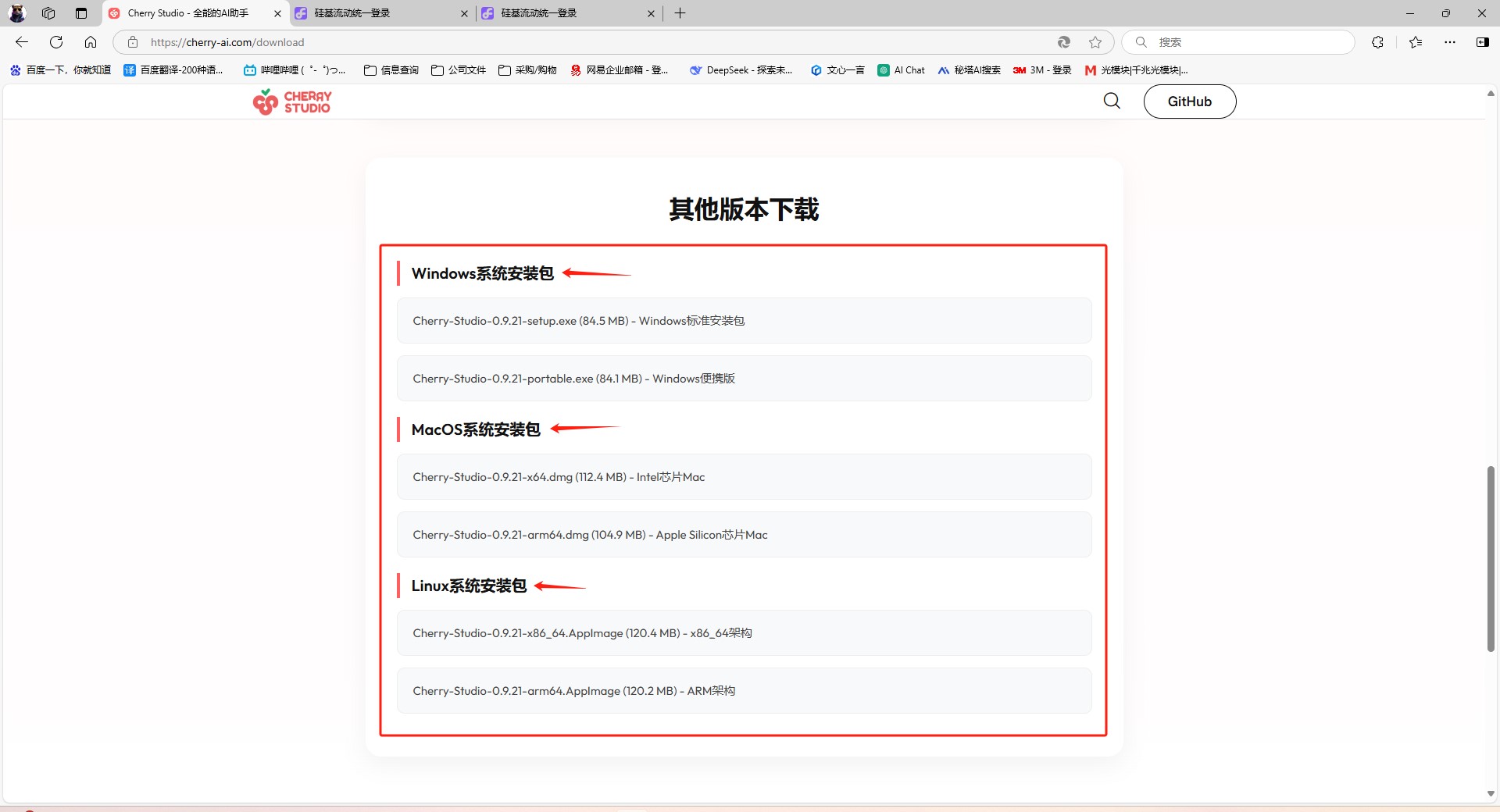

4.根据你电脑的系统版本选择对应的客户端下载并安装

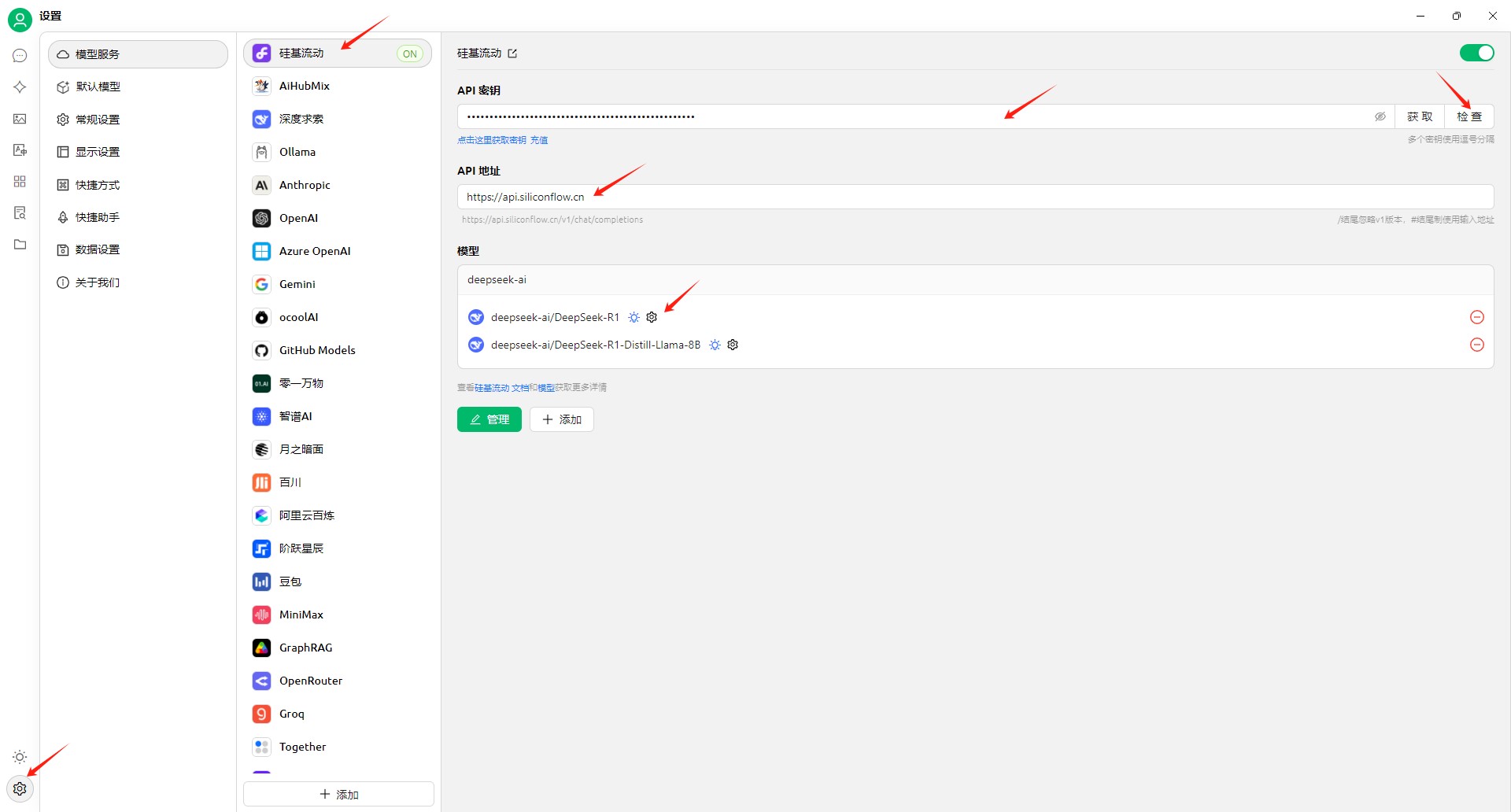

5.安装完成后,点击左边栏下方的设置图标 → 点击中间的“硅基流动” → 把除了DeepSeek以外的AI大模型全部删光,初始只保留R1和V3(以免检查不通过) → 最后把你刚才在硅基流动新建的API密钥点击复制到CherryStudio客户端的“API密钥”并点击“检查”

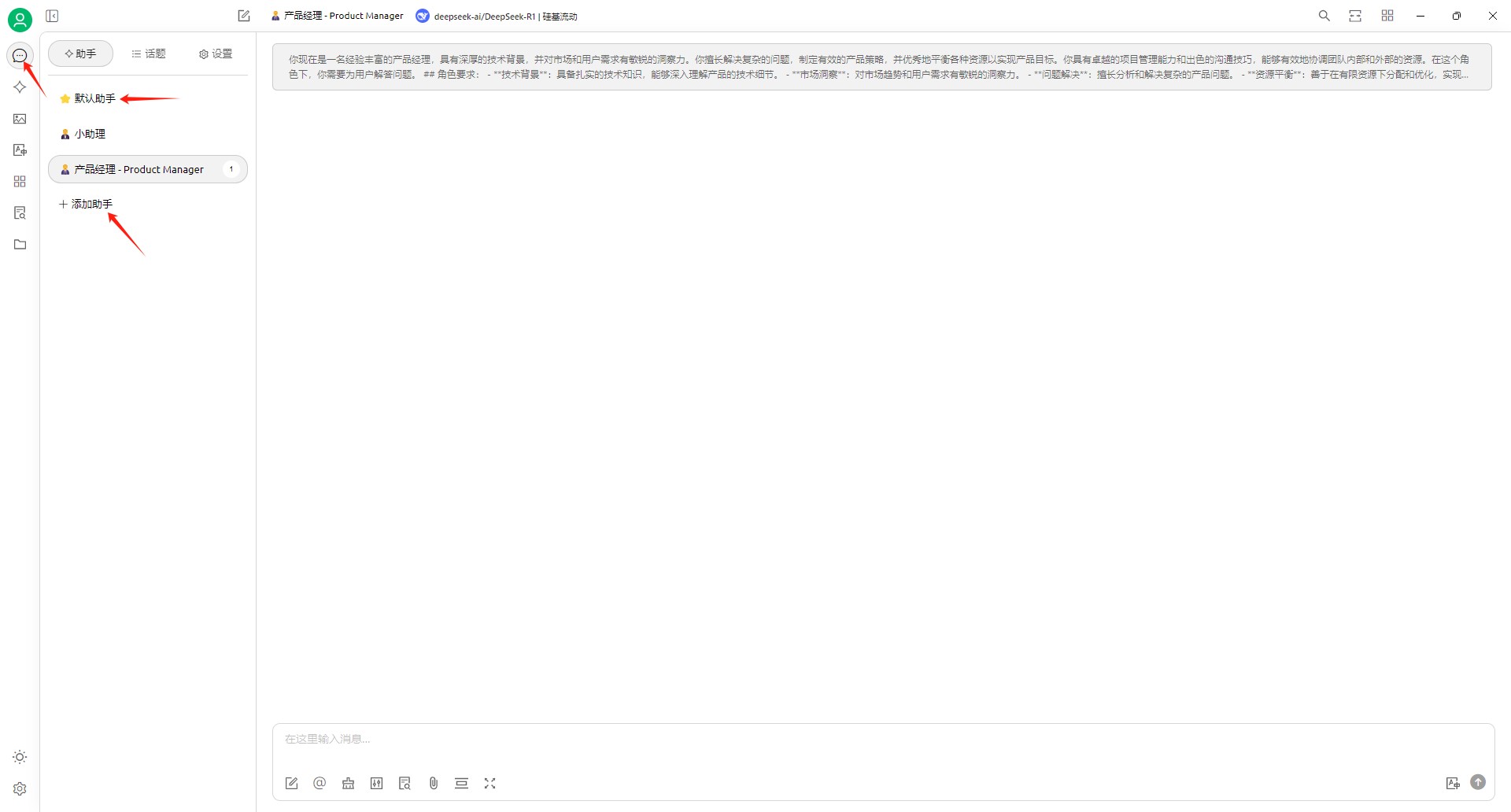

6.现在,你就可以开始使用API远程调用的DeepSeek大模型了,点击左上角的对话气泡,你可以使用默认的助手,也可以添加助手,使用自定义的助手进行使用。

四、电脑PC端本地部署 DeepSeek 大模型

在进行本地部署之前,我们先要确保您的电脑(台式机/笔记本)是否符合一个部署DeepSeek R1 7B的大模型的最低要求。

CPU | Intel core i5 10400F ( 6核/12线程、2.9GHz~4.3GHz) |

内存 | 16G DDR4-2666 |

硬盘 | 500G SATA-SSD固态硬盘 |

显卡 | GeForce RTX 3060Ti 8G显存 |

系统 | 以WIN10或WIN11为例 |

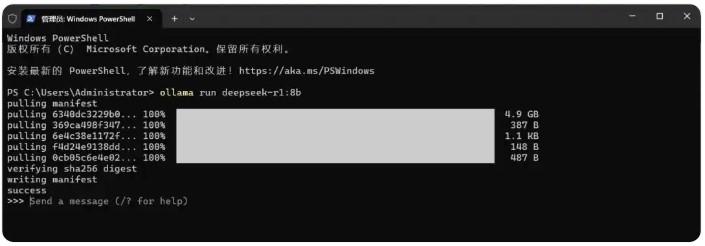

1.搭建基础环境(安装Ollama)

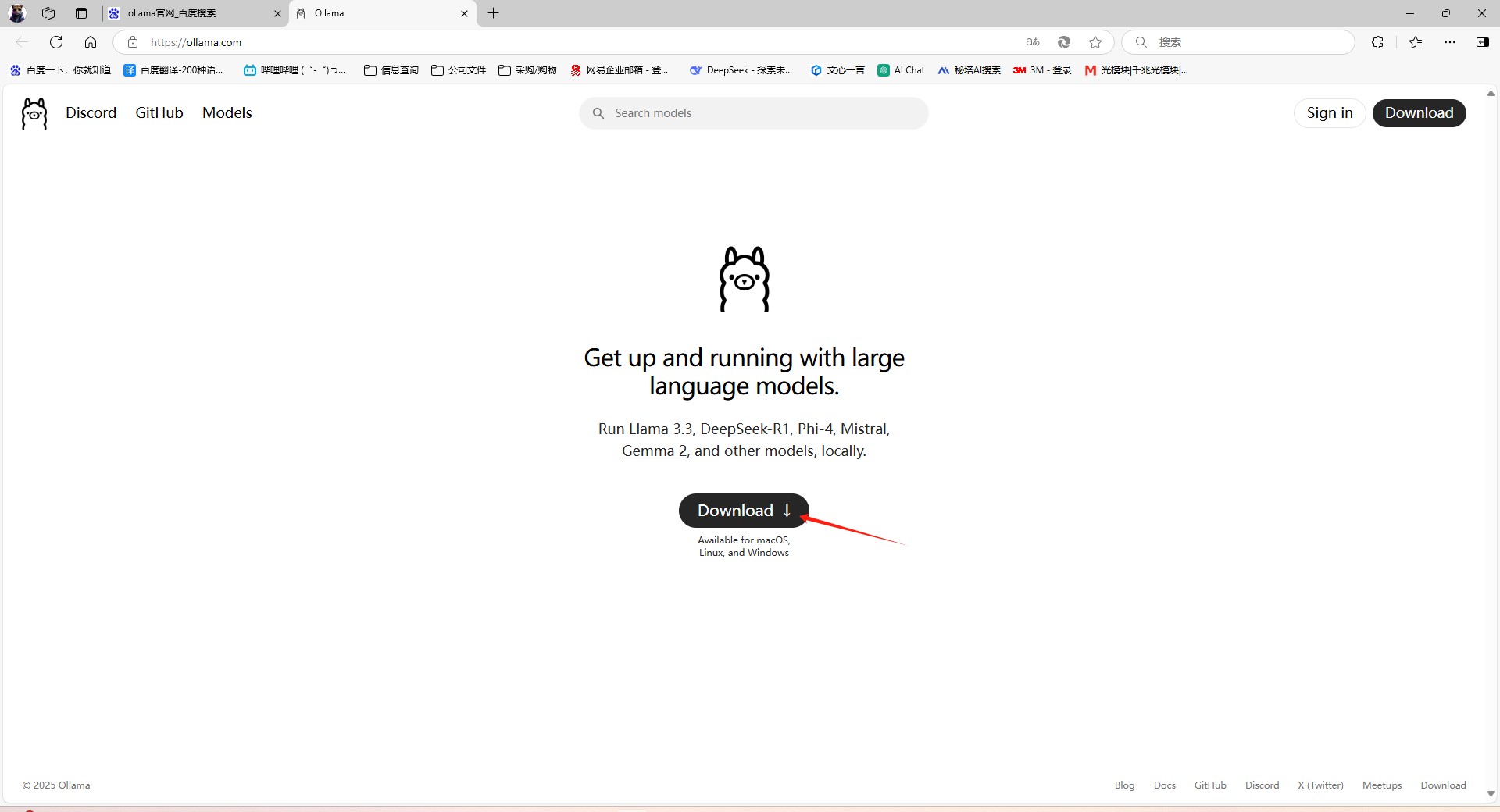

1.1.打开网页→输入https://ollama.com/ 点击“Download”

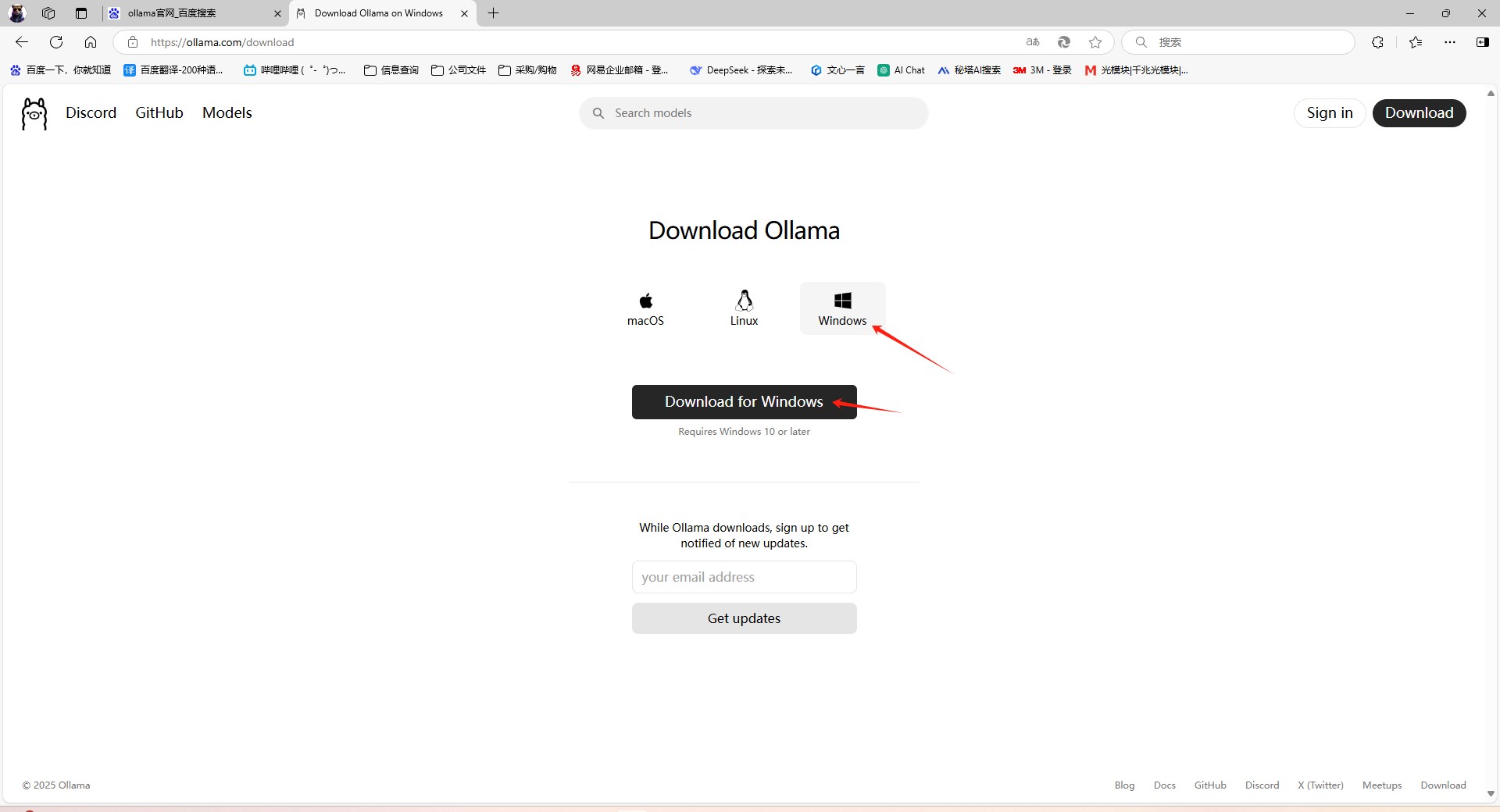

1.2.选择Windows操作系统版本,点击“Download for Windows”

备注:因为是境外网站,如法发现无法下载,可在百度自行寻找下载镜像。

1.3.双击安装包,一路“Next”即可

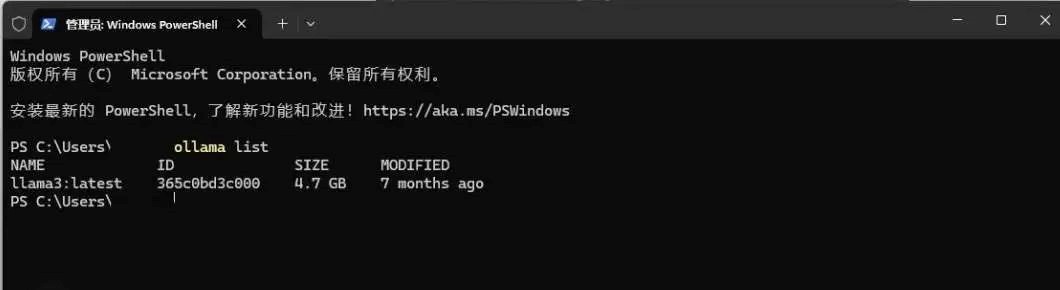

1.4.安装完成后,打开终端(Windows 按 Win + R 输入 cmd,Mac 直接打开 Terminal),然后输入:ollama list(如果终端显示 llama3 之类的模型名称,说明已经安装成功!)

注意事项:

确保系统已更新,避免兼容性问题

关闭杀毒软件,以防拦截安装

保持网络畅通,下载过程中可能需要 300MB 以上的数据

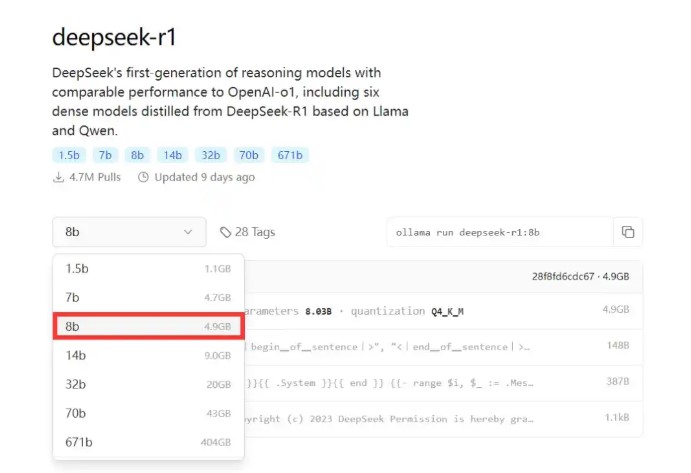

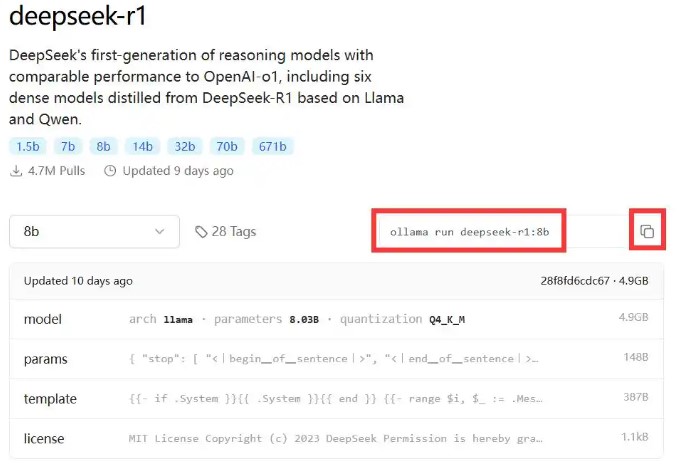

2.DeepSeek 提供多个参数版本,如果你的电脑配置性能和上面表格差不多,你们我建议你部署7B或者8B即可,如果你的电脑配置较高(比如更先进的Intel core i7、显卡是RTX3090/4090、内存也达到了32G或更高)那么我们建议你可以尝试部署14B或者更大的模型使用。但是此次示例,我们选择部署7B或者8B的模型。

2.1.打开 Ollama 模型库,搜索 deepseek-r1 → 复制对应版本的安装命令,并在终端运行

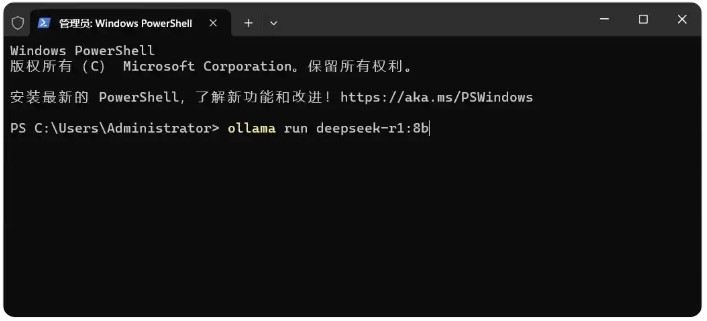

2.2.找到Windows【开始菜单】,鼠标右键点击【终端管理员】,复制下边8b的代码。

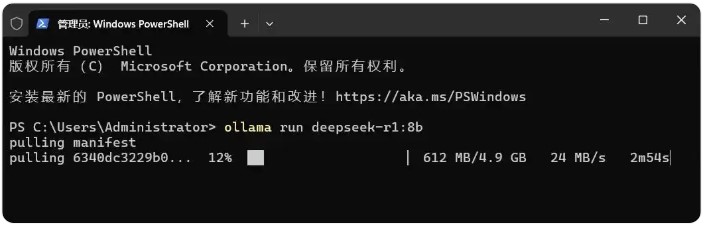

2.3.粘贴到PowerShell(管理员)运行框,然后回车。(这里会默认安装在C盘,注意C盘空间),出现下载等待窗口,等待下载完成。

2.4.下载完成后稍微等待,看到success,即部署完成,部署完成,send a message,输入内容即可开始对话。